Dilemme biais-variance

|

Read other articles:

Kaisar Zhao dari HanKaisar Dinasti HanBerkuasa87–74 SMPendahuluKaisar WuPenerusPangeran He dari ChangyiInformasi pribadiKelahiran94 SMChang'an, Kekaisaran HanKematian74 SM (usia 20)Chang'an, Kekaisaran HanPemakamanMausoleum PinglingWangsaWangsa LiuNama lengkapLiu Fuling 劉弗陵Shĭyúan 始元 (86 SM – 80 SM)Yúanfèng 元鳳 (80 SM – 75 SM)Yúanpíng 元平 (74 SM)Nama anumertaXiaozhao Huangdi (Hanzi: 孝昭皇帝; Pinyin: Xiàozhāo Huángdì), Zhao Di (Hanzi: 昭帝; Pi...

The Greatest ShowmanPoster filmSutradaraMichael GraceyProduser Laurence Mark Peter Chernin Jenno Topping Skenario Jenny Bicks Bill Condon CeritaJenny BicksPemeran Hugh Jackman Zac Efron Michelle Williams Rebecca Ferguson Zendaya Penata musik John Debney Joseph Trapanese SinematograferSeamus McGarveyPenyunting Tom Cross Robert Duffy Joe Hutshing Michael McCusker Jon Poll Spencer Susser PerusahaanproduksiChernin EntertainmentSeed ProductionsLaurence Mark ProductionsTSG EntertainmentDistri...

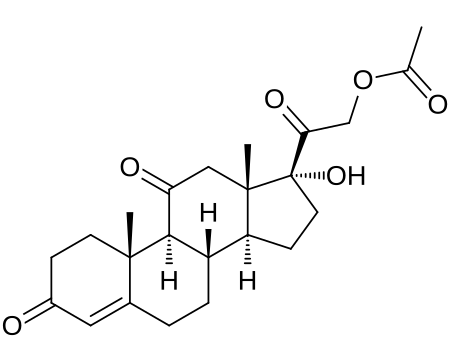

Chemical compound Cortisone acetateClinical dataTrade namesAdreson, Cortison, Cortisone, Cortisone Acetate, Cortone, Cortistab, Cortisyl, othersOther namesCortisone 21-acetate; 17α,21-Dihydroxypregn-4-ene-3,11,20-trione 21-acetateDrug classCorticosteroid; GlucocorticoidIdentifiers IUPAC name [2-[(8S,9S,10R,13S,14S,17R)-17-hydroxy-10,13-dimethyl-3,11-dioxo-1,2,6,7,8,9,12,14,15,16-decahydrocyclopenta[a]phenanthren-17-yl]-2-oxoethyl] acetate CAS Number50-04-4PubChem CID5745DrugBankDB01380ChemSp...

Voce principale: Vicenza Calcio. Questa voce sull'argomento stagioni delle società calcistiche italiane è solo un abbozzo. Contribuisci a migliorarla secondo le convenzioni di Wikipedia. Segui i suggerimenti del progetto di riferimento. Associazione Del Calcio Di VicenzaStagione 1926-1927Sport calcio SquadraVicenza Calcio Allenatore Imre János Bekey Presidente Tullio Cariolato Seconda Divisione3º posto nel girone C Nord 1925-1926 1927-1928 Si invita a seguire il modello di voce Stag...

† Человек прямоходящий Научная классификация Домен:ЭукариотыЦарство:ЖивотныеПодцарство:ЭуметазоиБез ранга:Двусторонне-симметричныеБез ранга:ВторичноротыеТип:ХордовыеПодтип:ПозвоночныеИнфратип:ЧелюстноротыеНадкласс:ЧетвероногиеКлада:АмниотыКлада:Синапсиды�...

Nicole Melichar-MartinezMelichar di Kejuaraan Wimbledon 2019Kebangsaan Amerika SerikatTempat tinggalStuart, Florida, A.S.Lahir29 Juli 1993 (umur 30)Brno, Republik CekoTinggi181 cm (5 ft 11 in)Total hadiahUS$ 2,154,371TunggalRekor (M–K)140–137 (50.54%)Gelar0 WTA, 2 ITFPeringkat tertinggiNo. 400 (24 September 2012)GandaRekor (M–K)345–287 (54.59%)Gelar12 WTA, 1 WTA 125Peringkat tertinggiNo. 9 (17 Mei 2021)Peringkat saat iniNo. 17 (6 Maret 2023)Hasil terbaik di Gr...

Cet article est une ébauche concernant une localité anglaise. Vous pouvez partager vos connaissances en l’améliorant (comment ?) selon les recommandations des projets correspondants. Maryport Administration Pays Royaume-Uni Nation Angleterre Comté Cumbria Démographie Population 9 639 hab. Géographie Coordonnées 54° 42′ 55″ nord, 3° 29′ 53″ ouest Localisation Géolocalisation sur la carte : Royaume-Uni Maryport Géolocalisat...

Les montagnards quittant l'aoul, par Pyotr Gruzinsky (en), 1872 Le terme moderne nettoyage ethnique des Circassiens, également qualifié de déportation désigne l'expulsion des Circassiens de la Circassie historique, soit approximativement la majeure partie de la Ciscaucasie au nord-est de la mer Noire, vers l'Empire ottoman et dans une moindre mesure vers la Perse Kadjare à la suite de la guerre du Caucase, gagnée par l'Empire russe qui les remplaça par les cosaques du Kouban et du...

Stadion Yanmar Nagai Informasi stadionPemilikOsaka CityLokasiLokasiOsaka, JapanKoordinat34°36′50″N 135°31′06″E / 34.61389°N 135.51833°E / 34.61389; 135.51833KonstruksiDibuka1964Diperbesar1996Direnovasi2007Data teknisPermukaanRumput (107 m x 71 m)Kapasitas50.000Ukuran lapangan105 x 68 mPemakaiCerezo Osaka (1996-kini)Kejuaraan Dunia Atletik IAAF (2007)Sunting kotak info • L • BBantuan penggunaan templat ini Stadion Yanmar Nagai (大阪市長居�...

Edition of music award ceremony This article does not cite any sources. Please help improve this article by adding citations to reliable sources. Unsourced material may be challenged and removed.Find sources: 2009 MTV Video Music Brazil – news · newspapers · books · scholar · JSTOR (May 2010) (Learn how and when to remove this message) Award2009 MTV Video Music BrazilDateOctober 01, 2009LocationCredicard HallHosted byMarcelo AdnetTelevision/radio cover...

Fictional character in the Star Wars franchise For the television series, see Obi-Wan Kenobi (miniseries). Fictional character Obi-Wan KenobiStar Wars characterAlec Guinness as Obi-Wan Kenobi in Star Wars: Episode IV – A New Hope (1977)First appearanceStar Wars (1977)Created byGeorge LucasBased onGeneral Makabe Rokurōtaby Akira KurosawaPortrayed by Alec Guinness (Episodes IV–VI) Ewan McGregor (Episodes I–III, Obi-Wan Kenobi) Voiced byas Ben Kenobi: Stephen Stanton (Star Wars: Battlefro...

Voce principale: Savona 1907 Foot-Ball Club. Questa voce sull'argomento stagioni delle società calcistiche italiane è solo un abbozzo. Contribuisci a migliorarla secondo le convenzioni di Wikipedia. Segui i suggerimenti del progetto di riferimento. Associazione Calcio SavonaStagione 1942-1943Sport calcio Squadra Savona Allenatore Rinaldo Roggero Presidente Ugo Noceti Serie B17º posto. Retrocessioni annullate dalla FIGC a fine stagione. Poi ammessa alla Serie B-C Alta Italia 1945...

「俄亥俄」重定向至此。关于其他用法,请见「俄亥俄 (消歧义)」。 俄亥俄州 美國联邦州State of Ohio 州旗州徽綽號:七葉果之州地图中高亮部分为俄亥俄州坐标:38°27'N-41°58'N, 80°32'W-84°49'W国家 美國加入聯邦1803年3月1日,在1953年8月7日追溯頒定(第17个加入联邦)首府哥倫布(及最大城市)政府 • 州长(英语:List of Governors of {{{Name}}}]]) •&...

Historic railway in southern Finland (1872–75) This article does not cite any sources. Please help improve this article by adding citations to reliable sources. Unsourced material may be challenged and removed.Find sources: Hanko–Hyvinkää railway – news · newspapers · books · scholar · JSTOR (October 2021) (Learn how and when to remove this message) Hanko–Hyvinkää railwayOverviewHeadquartersHankoLocaleFinland Dates of operation1872–1875...

Marine Fighter Attack Squadron 531VMFA-531 InsigniaActive16 November 1942 – 27 March 1992CountryUnited StatesAllegianceUnited States of AmericaBranchUnited States Marine CorpsTypeFighter/AttackRoleClose air supportAir interdictionAerial reconnaissancePart ofInactiveNickname(s)Grey GhostsTail CodeECEngagementsWorld War IIVietnam WarCommandersNotablecommandersLtCol Robert P. KellerLtCol John F. GoodmanLtCol Keith StalderAircraft flownBomberLockheed PV-1 VenturaDouglas SBD DauntlessCurti...

Provincia di Almeríaprovincia(ES) Provincia de Almería LocalizzazioneStato Spagna Comunità autonoma Andalusia AmministrazioneCapoluogoAlmería TerritorioCoordinatedel capoluogo37°10′N 2°20′W37°10′N, 2°20′W (Provincia di Almería) Superficie8 774 km² Abitanti635 850 (2006) Densità72,47 ab./km² Altre informazioniLinguecastigliano Cod. postale04 Prefisso950 e 850 Fuso orarioUTC+1 ISO 3166-2ES-AL Codice INE04 Nome abitantialmeriense Rappresentanza parla...

SIUE Graduate SchoolTypePublicDeanJerry WeinbergLocationEdwardsville, Illinois, U.S.Websitewww.siue.edu/graduate Southern Illinois University Edwardsville Graduate School is a post-graduate academic unit of Southern Illinois University Edwardsville (SIUE) located in Edwardsville, Illinois, United States. It offers 48 master's degree programs, 2 specialist degrees,[1] 17 post-baccalaureate and post-masters certificates,[2] doctoral programs in Education Administration and Nursi...

System installed in trains to prevent collisions through driver error For British Rail's implementation of ATP, see Automatic Train Protection (United Kingdom). ATP switchboard in a Taiwan Railways Administration DR2700 series carriage Automatic Train Protection notice on a First Great Western InterCity 125 Automatic train protection (ATP) is the generic term for train protection systems that continually check that the speed of a train is compatible with the permitted speed allowed by signall...

State park in Madison County, New York Chittenango Falls State ParkChittenango Falls in May 2007Location of Chittenango Falls State Park within New York StateTypeState parkLocation2300 Rathbun Road Cazenovia, New York[1]Nearest citySyracuse, New YorkCoordinates42°59′N 75°51′W / 42.98°N 75.85°W / 42.98; -75.85Area193 acres (0.78 km2)[2]Created1922 (1922)[3]Operated byNew York State Office of Parks, Recreation and Histo...

American college football season 1932 college football seasonA Depression-Era audience at the Michigan-Illinois gameNumber of bowls1Bowl gamesJanuary 2, 1933Champion(s)MichiganUSC ← 1931 · football seasons · 1933 → The 1932 college football season saw the Michigan Wolverines win the Knute Rockne Memorial Trophy as national champion under the math-based Dickinson System. Because the Big Nine conference didn't permit its teams to play in the postseason, ho...

![{\displaystyle {\begin{aligned}\mathrm {E} \left[\left(y-{\hat {f}}(x)\right)^{2}\right]&=\mathrm {Biais} \left[{\hat {f}}(x)\right]^{2}+\mathrm {Var} \left[{\hat {f}}(x)\right]+\sigma ^{2}\\\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2947461631a74a154f6da6a3f91f0fe498d149fa)

![{\displaystyle {\begin{aligned}\mathrm {Biais} \left[{\hat {f}}(x)\right]=\mathrm {E} \left[{\hat {f}}(x)-f(x)\right]\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9ea78f291090869b0e83987304f7706b743cf5c2)

![{\displaystyle {\begin{aligned}\mathrm {Var} \left[{\hat {f}}(x)\right]=\mathrm {E} \left[\left({\hat {f}}(x)-\mathrm {E} [{\hat {f}}(x)]\right)^{2}\right]\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8b7cc24047b536def6fc7fe6a6cafa0d2d0942bc)

![{\displaystyle {\begin{aligned}\mathrm {Var} [X]=\mathrm {E} [X^{2}]-\mathrm {E} [X]^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f13fdb9db4a119c8d00e220bb7cf51637b1792a4)

![{\displaystyle {\begin{aligned}\mathrm {E} [X^{2}]=\mathrm {Var} [X]+\mathrm {E} [X]^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e4a8980facc6722d88b8350bf04230d428ec245c)

![{\displaystyle {\begin{aligned}\mathrm {E} [f]=f\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8cd3852100c919ebb3c8a3085ed8e14268d0393f)

![{\displaystyle \mathrm {E} [\epsilon ]=0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f7494dee92fe5ac5a8d8a61fa72e73482ad679d9)

![{\displaystyle \mathrm {E} [y]=\mathrm {E} [f+\epsilon ]=\mathrm {E} [f]=f}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6a027bc2f4ced7f9af72c462a548d72d285aa788)

![{\displaystyle \mathrm {Var} [\epsilon ]=\sigma ^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4ed97af78f7548bb5ebb8ae3a04101a3c8a25511)

![{\displaystyle {\begin{aligned}\mathrm {Var} [y]=\mathrm {E} [(y-\mathrm {E} [y])^{2}]=\mathrm {E} [(y-f)^{2}]=\mathrm {E} [(f+\epsilon -f)^{2}]=\mathrm {E} [\epsilon ^{2}]=\mathrm {Var} [\epsilon ]+\mathrm {E} [\epsilon ]^{2}=\sigma ^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/459eaadae3f6c660fbefa85b4c14ef1d3e78c444)

![{\displaystyle {\begin{aligned}\mathrm {E} \left[(y-{\hat {f}})^{2}\right]&=\mathrm {E} \left[y^{2}+{\hat {f}}^{2}-2y{\hat {f}}\right]\\&=\mathrm {E} [y^{2}]+\mathrm {E} \left[{\hat {f}}^{2}\right]-\mathrm {E} [2y{\hat {f}}]\\&=\mathrm {Var} [y]+\mathrm {E} [y]^{2}+\mathrm {Var} [{\hat {f}}]+\mathrm {E} [{\hat {f}}]^{2}-2f\mathrm {E} [{\hat {f}}]\\&=\mathrm {Var} [y]+\mathrm {Var} [{\hat {f}}]+(f-\mathrm {E} [{\hat {f}}])^{2}\\&=\mathrm {Var} [y]+\mathrm {Var} [{\hat {f}}]+\mathrm {E} [f-{\hat {f}}]^{2}\\&=\sigma ^{2}+\mathrm {Var} [{\hat {f}}]+\mathrm {Biais} [{\hat {f}}]^{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fb5044a73c743637f4b4a3af2386a012e254349f)

![{\displaystyle \mathrm {E} [(y-{\hat {f}}(x))^{2}]=\left(f(x)-{\frac {1}{k}}\sum _{i=1}^{k}f(N_{i}(x))\right)^{2}+{\frac {\sigma ^{2}}{k}}+\sigma ^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2852b9b12eb56a64c35b4eb49b9e3b19b665da2f)